Kestra: guía práctica para automatización de flujos de trabajo y orquestación open‑source

Tiempo estimado de lectura

Aprox. 12–18 minutos. Lectura pensada para ingenieros de datos, SREs y equipos de IA/no‑code.

Puntos clave (Key takeaways)

- Kestra es un orquestador declarativo (YAML) con UI que facilita colaboración entre equipos técnicos y no‑técnicos.

- Soporta integraciones listas (S3, Google Sheets, Kafka, LLMs) mediante plugins y tareas HTTP.

- Útil para POCs rápidos con IA y para pipelines reproducibles; para k8s‑native a escala, otras opciones pueden encajar mejor.

- Instalación local sencilla con Docker; plantilla práctica CSV→IA→Google Sheets disponible en el repo.

Tabla de contenido

- Introducción — ¿por qué Kestra?

- Conceptos clave

- Comparativa con otras plataformas

- Primeros pasos: Docker local

- Integración de modelos e IA

- Agentes y alternativas

- Buenas prácticas y seguridad

- Escalado y operaciones

- Casos de uso

- Recursos y plantillas

- Preguntas frecuentes (FAQ)

- Conclusión y próximos pasos

Introducción — ¿por qué Kestra?

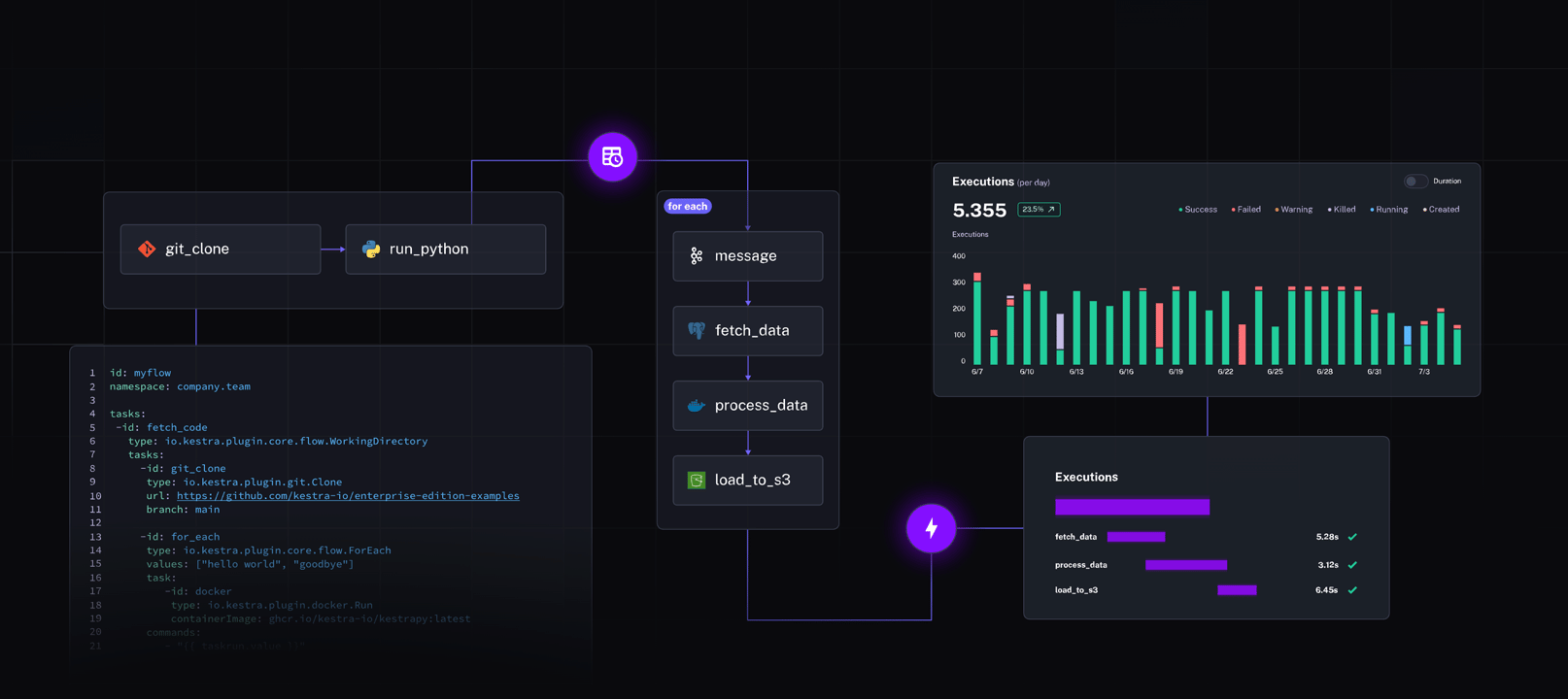

Kestra es una plataforma open‑source de orquestación diseñada para automatizar flujos de trabajo complejos y heterogéneos. En una sola frase: organiza tareas, gestiona dependencias y conecta sistemas (S3, Kafka, APIs, Google Sheets, LLMs) con YAML declarativo y una UI clara.

Por qué leer esta guía:

- Verás cómo instalar Kestra en local con Docker y ejecutar tu primer flujo en minutos.

- Te mostraremos la filosofía que la hace útil para data engineers, SREs y equipos de IA/no‑code.

- Al final del primer bloque tendrás claridad para arrancar un pipeline real (por ejemplo: automatización de CSV a Google Sheets con IA).

Para quién sirve Kestra:

- Equipos de datos que necesitan pipelines reproducibles.

- Equipos de IA que orquestan llamadas a modelos y transformaciones.

- Equipos no‑técnicos que quieren colaborar con YAML y una UI low‑code.

Lectura recomendada: reseña y contexto en WWWhatsNew.

Conceptos clave de Kestra (breve y práctico)

Aquí están los conceptos que usarás todos los días. Piensa en Kestra como un director de orquesta: no toca cada instrumento, pero decide qué, cuándo y con quién tocar.

Flujos (flows) y tareas (tasks)

– Flow: un pipeline completo (p. ej. “procesar ventas diaria”).

– Task: acción atómica dentro del flow (descargar CSV, llamar a una API, escribir a Google Sheets).

Ejemplo simple: download_csv → parse_csv → enrich_with_ai → write_to_sheets. Cada bloque se define en YAML y produce salidas que pueden encadenarse.

Sistema de plugins y almacenamiento de estado

- Plugins: adaptadores listos para S3, Google Sheets, OpenAI, Kafka, etc.

- Almacenamiento: Kestra delega estado y artefactos a backends (S3, filesystem) y usa brokers para colas si lo necesitas.

Más detalles técnicos: documentación de features.

Orquestación vs scheduler

– Scheduler (cron): ejecuta tareas en tiempos fijos.

– Orquestador (Kestra): reacciona a eventos, maneja dependencias complejas y coordina tareas asíncronas.

Ventaja práctica: si un flujo depende de la llegada de un archivo a S3 o de la respuesta lenta de un LLM, Kestra gestiona retries, timeouts y ramificaciones sin que escribas un hilo de control en Python.

Herramientas de orquestación AI nativas

Kestra facilita integrar modelos LLM mediante tareas HTTP o plugins específicos. Así puedes:

- Enriquecer registros con un LLM.

- Validar salidas automáticamente.

- Generar prompts dinámicos según contexto.

Lectura recomendada sobre integración: artículo en Modal.

Comparativa: Kestra frente a otras plataformas open‑source

Ficha rápida para decidir cuándo elegir Kestra. Piensa en este checklist como una ficha de diagnóstico.

Criterios clave

- Facilidad de uso: YAML declarativo + UI → colaboración entre ingeniería y no‑code.

- Soporte para tareas asíncronas: triggers event‑driven y manejo de colas.

- Integración con LLMs/IA: plugins y tasks HTTP facilitan llamadas a modelos.

- Escalabilidad: diseñado para crecer con backends distribuidos.

Resumen práctico:

- Airflow: potente ecosistema y comunidad, pero más centrado en DAGs Python.

- Argo / Flyte / Kubeflow: k8s‑native, ideal si estás 100% en Kubernetes.

- Prefect / Dagster: experiencia de desarrollador fuerte en Python.

- Kestra: equilibrio entre declarativo (YAML), UI accesible y conectores listos para IA.

Más contexto: reseña y comparativa.

Primeros pasos: instalar Kestra en local con Docker (guía paso a paso)

En esta sección vas a instalar y verificar Kestra en tu máquina. Sencillo y reproducible: copia‑pega y listo.

Requisitos previos

- Docker y docker‑compose instalados.

- Al menos 4 GB de RAM para un entorno de desarrollo cómodo.

- Puertos libres (por defecto usaremos 8080 para la UI).

Comando docker‑compose mínimo

Crea un archivo docker‑compose.yml con lo siguiente (versión simplificada para desarrollo):

version: "3.7"

services:

kestra:

image: kestra/kestra:latest

ports:

- "8080:8080"

volumes:

- ./flows:/app/flows

Explicación rápida: kestra: contenedor que corre el servidor y la UI. volumes: aquí pondrás tus YAML de flows para que Kestra los detecte.

Verificación paso a paso

- Levanta los servicios:

docker compose up -d - Abre la UI: http://localhost:8080

- Sube un flow de ejemplo en la carpeta

./flowsy recarga la UI. - Ejecuta el flow y observa logs y outputs en la interfaz.

Troubleshooting común

- Puerto 8080 ocupado: cambia el mapeo de puertos en docker‑compose.

- Permisos de volumen: en Linux, verifica ownership de

./flows. - Versión de Docker antigua: actualiza a la última versión estable.

Repositorio y docs con ejemplos más completos: GitHub Kestra · Docs de features: Scheduling & Automation.

(Si quieres, después agrego un docker‑compose más completo con S3 local y plugin catalog.)

Qué probar ahora (rápido):

- Sube un CSV pequeño a

./flowscomo artefacto y crea un flow que lo lea. - Observa la ejecución y prueba a fallar una task para ver retries y logs.

Integración de modelos e IA: copiloto IA para automatización y agentes no‑code

Conectar modelos LLM desde Kestra es directo: puedes usar tasks HTTP estándar, plugins existentes o crear un wrapper personalizado para cualquier API (OpenAI, Azure, modelos locales). Esto permite enriquecer, validar o generar datos dentro de un flujo sin salir del entorno de orquestación.

Lectura complementaria: artículo de Modal.

Diseño práctico de un copiloto IA

- Task que genera prompts dinámicos a partir del contexto del flujo.

- Task que llama al LLM para clasificar o enriquecer registros.

- Task que valida la salida (p. ej. esquema, valores permitidos) y decide si reintentar o escalar.

Patrones de integración

- “Validate → Enrich → Approve”: LLM sugiere correcciones, otra task automática valida y, si falla, se notifica a un humano.

- “Batch + RAG”: indexas datos clave (embedding + vector DB) y haces llamadas al LLM con contexto relevante.

Integración no‑code y agentes

Puedes delegar pasos a Make o Zapier por webhook cuando quieras exponer un paso a usuarios menos técnicos. Para agentes no‑code que toman decisiones, lo habitual es que Kestra orqueste la ejecución y registre las entradas/salidas para auditoría.

Precauciones

- Controla tokens y costes de llamadas a LLM.

- Ten políticas de retry y límites de latencia para evitar cuellos de botella en el pipeline.

Alternativas a Sim AI y Nathan — cómo elegir un agente y cuándo integrarlo con Kestra

Qué evaluar al escoger un agente:

- Seguridad y trazabilidad: ¿permite auditar acciones y conservar historial?

- Integración: ¿tiene API/webhooks para conectarse con Kestra?

- Coste y límites: ¿cómo escala el modelo con volúmenes reales?

- Control y sandboxing: ¿puedes limitar acciones automatizadas?

Alternativas recomendadas:

- LangChain agents o LlamaIndex para arquitecturas centradas en RAG.

- AutoGPT y agentes autónomos para exploración (con controles estrictos).

- Copilotos empresariales (Microsoft Copilot, Google Vertex AI Agents) para ecosistemas específicos.

- Herramientas no‑code (Make, Zapier) para orquestación ligera y prototipos.

Arquitectura híbrida típica: Kestra ejecuta el flujo base; un agente externo sugiere o decide pasos via webhook; Kestra registra la decisión y ejecuta la acción aprobada.

Recomendación práctica: comienza integrando agentes en modo “sugerencia” antes de dar permisos de ejecución automática.

Buenas prácticas, seguridad y observabilidad en Kestra

Versionado y pruebas

- Mantén todos los flows en Git. Usa ramas para dev/staging/prod.

- Prueba localmente con datos de muestra y mocks de APIs antes de producción.

Gestión de secretos

- No pongas claves en YAML. Usa HashiCorp Vault, Kubernetes Secrets o variables de entorno cifradas.

- Rotación periódica de claves y control de acceso basado en roles.

Logging y trazabilidad

Activa logs detallados y guarda artefactos relevantes (inputs/outputs) en S3 o un storage central. Usa la UI de Kestra para revisar ejecuciones y configurar alertas en fallos críticos.

Fuente y contexto: reseña.

Políticas de errores

- Define retries exponenciales, timeouts claros y circuit breakers para llamadas a LLM/APIs externas.

- Implementa notificaciones (Slack/email) para errores que requieren intervención humana.

Privacidad y cumplimiento

- Para datos sensibles, anonimiza antes de enviarlos a terceros (LLMs externos).

- Revisa contratos y memorandos de privacidad de proveedores de IA.

Escalado y operaciones: llevar Kestra a producción

Estrategias de escalado

- Escala workers horizontalmente para procesamiento paralelo de tasks.

- Usa un broker robusto (Kafka/Redis/SQS) si manejas volúmenes altos o colas densas.

Kubernetes y alta disponibilidad

Despliega Kestra en k8s para resiliencia, auto‑escalado y gestión avanzada de recursos. Usa almacenamiento compartido (S3 / MinIO) para artefactos y resultados.

Optimización para ETL y cargas grandes

- Particiona archivos grandes y procesa en chunks.

- Prefiere tareas IO‑bound optimizadas y evita bloquear workers con llamadas síncronas largas: externaliza a colas o subflows asíncronos.

Observability y SLOs

Define SLOs para latencia y éxito de ejecuciones. Conecta métricas de Kestra a Prometheus/Grafana para alertas proactivas.

Docs de features: Kestra features.

Casos de uso y ejemplos reales con Kestra

Ideas aplicables de inmediato:

- BI: ingestion diaria, enriquecimiento y normalización para un data warehouse.

- Reports comerciales: CSV → enriquecimiento IA → Google Sheets para equipos de ventas.

- ML Ops: orquesta entrenamiento, validación y despliegue con triggers basados en datos.

- Soporte y legal: copilotos que resumen tickets y marcan prioridad.

Mini‑case: Empresa de e‑commerce: Kestra detecta archivo S3 con órdenes, lo parsea, un LLM clasifica pedidos de riesgo, y los resultados se suben a Google Sheets para revisión humana. Todo auditado y con alertas si un porcentaje supera umbrales.

Recursos, plantillas y snippets descargables

Checklist rápido para producción:

- Flujos versionados en Git.

- Secrets en Vault/K8s.

- Monitorización y alertas configuradas.

- Pruebas end‑to‑end con datos sintéticos.

Plantilla YAML (descargable)

Proporcionamos un repo con la plantilla CSV→IA→Google Sheets lista para adaptar y ejecutar en Docker local. Incluye ejemplos de variables, manejo de secretos y políticas de retry.

Enlaces útiles

- Repositorio oficial Kestra: GitHub Kestra

- Docs y features: Kestra Scheduling & Automation

- Artículo sobre integración con Modal: Modal + Kestra

- Reseña y contexto general: WWWhat sNew

Llamados a la acción:

- Descarga la plantilla YAML.

- Prueba el demo local con Docker.

- Suscríbete a la newsletter técnica para recibir updates y ejemplos.

Preguntas frecuentes (FAQ)

¿Kestra es mejor que Airflow para mi caso?

Depende. Si quieres YAML declarativo, UI low‑code y rápida integración con APIs/LLMs, Kestra es una opción excelente. Para ecosistemas maduros de DAGs en Python con una comunidad más grande, Airflow puede encajar mejor. Más contexto: reseña.

¿Necesito Kubernetes para usar Kestra?

No. Para POCs y desarrollo local puedes usar Docker. Para producción, k8s aporta alta disponibilidad y escalado. (Fuente: Kestra features).

¿Cómo conecto OpenAI o Azure desde Kestra?

Vía task HTTP genérica, plugin oficial (si está disponible) o wrapper personalizado que maneje autentificación y parsing. Maneja claves con un gestor de secretos, nunca en YAML simple.

¿Puedo usar agentes no‑code con Kestra?

Sí. Integra Make/Zapier por webhooks o usa agentes externos vía API. Mejor empezar con modo “sugerencia” antes de dar permisos de ejecución automática.

¿Cómo auditar ejecuciones y resultados?

Kestra guarda historial de ejecuciones y outputs. Complementa con almacenamiento de artefactos (S3) y logging centralizado para cumplir trazabilidad y cumplimiento.

¿Hay plantillas listas para CSV→Google Sheets con IA?

Sí. El repositorio vinculado incluye una plantilla base que puedes adaptar, junto con ejemplos de variables y gestión de secretos. Ver: GitHub Kestra.

Conclusión y próximos pasos recomendados

Kestra ofrece un equilibrio muy valioso entre simplicidad declarativa y poder operativo: facilita la automatización de flujos de trabajo desde prototipos locales hasta pipelines de IA en producción. Su enfoque en YAML, plugins y una UI colaborativa la hace especialmente útil para equipos multidisciplinares.

Ruta práctica sugerida:

- Instala Kestra en local con Docker y ejecuta el demo.

- Prueba la plantilla CSV→IA→Google Sheets con datos de ejemplo.

- Añade un LLM en modo validación y ajusta retries/timeouts.

- Versiona flows en Git y prepara despliegue en Kubernetes cuando pases a producción.

Pruébalo ahora: descarga la plantilla YAML, corre el demo local y comparte tus resultados con la comunidad. Kestra te permite automatizar desde tareas sencillas hasta orquestaciones complejas con IA de forma segura y auditable.